您的位置:主页 > 公司动态 > 公司新闻 > 公司新闻

AI统治人类,需要分几步走?-香港期货

你敢信托?ChatGPT已经通过图灵测试了!

甚至不是最新的GPT-4o,老版本GPT-3.5和GPT-4就已经打破人类和AI的最后一层限制。

“图灵测试”由盘算机科学家艾伦・图灵在1950年提出。他将人工智能给出了一个完全可操作的界说:若是一台机械输出的内容和人类大脑别无二致的话,那么我们就没有理由坚持以为这台机械不是在“思索”。

“图灵测试”和“机械人三定律”,一直被人类天下视为珍爱人类的最后屏障。

就连“AI讲师”周鸿祎,都在最近的社交平台上大谈AI灭世论,将AI焦虑拉到*。

在2024年,以OpenAI为首的大模子公司,真的能打开扑灭人类社会的潘多拉魔盒吗?

01

“AI灭世论”引发焦虑

从上世纪最先,通过图灵测试就成为人类在AI领域为之奋斗的里程碑目的。

可真的有AI通过测试后,人类的惊慌却大过于惊喜。

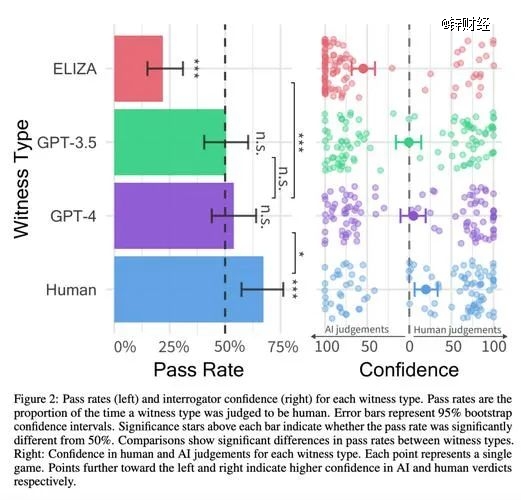

加州大学研究职员招募了500名介入者,让他们与四位“对话者”举行五分钟的交流,这四位“对话者”划分是:真人、上世纪60年月的初代谈天机械人ELIZA、GPT-3.5和GPT-4。

介入者在对话竣事后,需判断对方是人照样机械。

评估工具通过率(左) 评估者信托度(右)

效果显示,真人被准确识别的比例则为67%;ELIZA只有22%;GPT-4和GPT-3.5则高达54%、50%。

这项测试无疑是异常恐怖,真人和GPT-4的差距仅有12%!

前OpenAI“超级对齐团队”成员利奥波德·阿申布伦纳(Leopold Aschenbrenner),曾在在社交平台披露出来的一份长达165页的PDF文档,对外界发出忠告。

阿申布伦纳示意,AI在已往10年深度学习的提高速率异常惊人。仅仅10年前,AI识别简朴图像的能力就已经是革命性的。但现在,人类不停实验提出新颖的、更难的测试,但每个新的基准测试都很快被AI所破解。

已往,破解普遍使用的基准测试,AI需要数十年的时间,而现在只要几个月。

而图灵测试虽然名气大,但从问题深度和难度上,并不如当下最难题的基准测试,也就是类似GPQA的测试,内容是博士级其余生物、化学和物理问题。

阿申布伦纳估量,GPT-4进化到GPT-4o,或者到GPT-5模子迭代后,这一基准测试也将作废。

为什么人类设置的难题,会这么快被AI所破解?缘故原由就是,AI学习能力真的太快了!

泉源:利奥波德·阿申布伦纳

2019年宣布的GPT-2模子,智力水平仅仅于学龄前儿童相仿,只能简朴串起一些看似合理的句子,然则却无法从1数到5,也无法完成总结类义务;

2020年宣布的GPT-3模子,智力水平大致到达了小学生的水平,能天生篇幅更长的模子,并能完成一些基础的算术义务和语法纠错;

2022年宣布的GPT-4模子,智力水平就能与较为伶俐的高中生相似,能编写庞大的代码并举行迭代调试,还能完成高中数学竞赛题。

等到2024年,更先进GPT-4o,更是完成了对GPT-4的全方位逾越。

相对照人类,正凡人类从小学提升到初中,需要六年的时间;初中提升到高中,又需要三年的事宜。

而AI的进化,则是两年一个台阶的越级进化,远远跨越正凡人类的水平。

02

超级人工智能时代

二代何剑锋只能「创」到底了?

“在2027年,我们就有极大可能实现AGI(超级人工智能)。”

这是阿申布伦纳的推断,他的数据支持是GPT-2到GPT-4的模子迭代趋势。

从2019-2022年的4年时间里,ChatGPT算力和算法效率都在以每年0.5个数目级(1个数目级=10倍)的速率生长。

再加上可能泛起的释放模子性能的手艺突破,等到了2027年,AGI(超级人工智能)时代就会降临,AI工程师完全可以取代人类工程师的所有事情。

AI的“超级进化”,背后是算力与资源的巨额消耗。

AI研究机构Epoch AI评估讲述显示,GPT-4训练使用的原始盘算量比GPT-2多约3000-10000倍。

这无疑是个恐怖的数据,据阿申布伦纳估量,到2027年底,将会泛起2个数目级的算力增进,用电量相当于美国一其中小型的州的用电量。

也就是说,要拿一个省份的用电量,来支持起一个AI大模子的一样平常训练,这照样GPT-4的水准,还远不到AGI(超级人工智能)的尺度。

周鸿祎对阿申布伦纳的言论并不认同,甚至有些“不切现实,更像是科幻小说”。

他示意,若是一个AGI(超级人工智能)的降生就需要多个省份的电力资源,那么有10个以上的AGI,就能把整个地球的资源抽干殆尽。

周鸿祎给出了自己对AI的担忧,他以为若是在未来降生出一个AGI,它就会取代人类工程师认真对AI大模子的开发,那么就会有一个24小时日以继夜事情、让算法和手艺突破的更快,形成极为夸张的正循环。

在“机械人刷新机械人”“机械人刷新算法”的模式下,AI的智力水平会从人类进化到超人,那么就会上演“硅基生物VS碳基生物”的好莱坞戏码。

虽然周鸿祎否决阿申布伦纳的言论,但同样以为智能大爆炸之后的“超级智能时代”,将是人类历史上最动荡、最危险、最主要的时期。

这并不是周鸿祎在社交平台上,*次对AI领域充斥着忧虑。早在2023年年头,GPT-4刚刚火遍全球的时刻,周鸿祎就已经表达过对AI平安的担忧。

周鸿祎示意:原来的人工智能给人的感受像“人工智障”,虽然能做一些手艺好比人脸识别、语音识别,但并不能明白你说的什么。然则ChatGPT模子不仅能够通过图灵试验,而且它有自己的人设、自己的看法,根据进化速率、摩尔定律,若是进一步训练下去,ChatGPT也许就能实现自我意识的突破。

一旦自我意识突破,它就有可能控制全网的电脑,就会以为比人类高明许多。在它眼里,人类这个物种实在无论从存储、算力、反映能力、知识面上比它差太远,它就能反过来奴役人类,科幻正离现实越来越近。

作为360的首创人,AI平安问题,周鸿祎的挂念更多。

03

无人在意的AI平安

OpenAI作为AI时代的领头羊,面临AI平安的全球舆论,它做了什么吗?

显然是没有的,甚至OpenAI还在今年遣散了认真AI平安的“超级对齐团队”。

在去年,OpenAI首席科学家伊利亚·苏斯克沃就由于AI平安问题,对CEO山姆·奥特曼举行弹劾,但最终照样山姆·奥特曼笑到最后,伊利亚·苏斯克沃被赶出公司。

伊利亚·苏斯克沃脱离OpenAI后,在6月20日宣布确立新公司SSI(超级平安智能Safe SuperIntelligence)。

最在意AI平安的伊利亚·苏斯克沃去职,上文提到了利奥波德·阿申布伦纳就以“泄密”为由,被OpenAI同样赶出了公司。

这也是他在社交平台宣布165页的文档,曝光OpenAI的缘故原由。

甚至,曝光OpenAI的吹哨人,还不止阿申布伦纳一人,在上个月,有一批OpenAI的前员工和现员工团结起来,公然揭晓了一封联名信,声明OpenAI缺少羁系,人工智能系统已经能对人类社会造成严重危害,未来甚至能“灭绝人类”。

虽然“灭绝人类”这个说法过于惊悚,但在遣散超级对齐团队之后,OpenAI GPT商铺充斥着垃圾邮件,并违反平台的服务条款从YouTube抓取数据。

看到AI平何在OpenAI的职位,越来越多的平安研究职员,选择另谋高就。

艾隆·马斯克也忍不住抨击山姆·奥特曼:“平安并不是OpenAI的主要义务。”

对于外界的指斥,山姆·奥特曼置若罔闻,他已经把所有精神用于推动OpenAI彻底转向营利实体,不再由非营利性组织控制。

若是OpenAI转型为营利组织后,有限合资人每年利润分红的限制就不复存在了,巨额回报激励能够进一步扩大合资人局限,也有利于OpenAI走向IPO。

也就是说,估值高达860亿美元的OpenAI(约6244亿人民币),将能给山姆·奥特曼本人带来更多的财富。

在Dollar眼前,山姆·奥特曼毅然决然的放弃了AI平安。